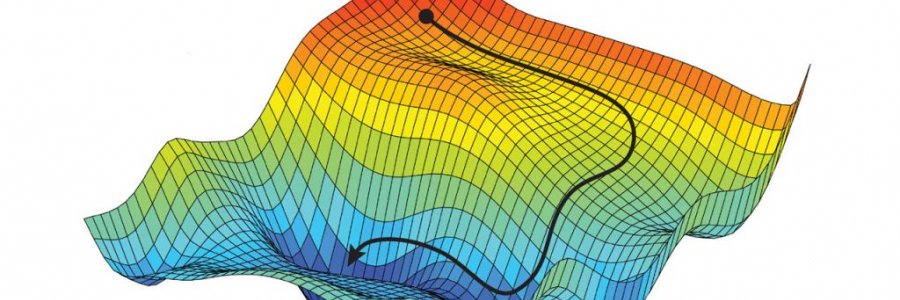

Il concetto di ottimizzazione gioca un ruolo chiave quando si parla di machine learning e deep learning in particolare. Lo scopo principale degli algoritmi di deep learning è quello di costruire un modello di ottimizzazione che, tramite un processo iterativo, minimizzi o massimizzi una funzione obiettivo $J(\theta)$ denominata anche loss function o cost function.

I più popolari metodi di ottimizzazione possono essere suddivisi in due categorie: metodi di ot…

In questo articolo viene descritto l'algoritmo YOLO per Object Detection. Ne vengono definite le caratteristiche fondamentali facendo qualche riferimento ai progressi che si sono conseguiti nella varie versioni rilasciate.

In questo articolo viene trattato uno storico algoritmo di ottimizzazione di tipo ensemble: il Gradient Boosting. Saranno descritte la teoria di base sulla quale questo algoritmo poggia e si cercherà di darne una descrizione quanto più possibile intuitiva attraverso un esempio pratico di regressione.

Nella prima puntata di questa serie abbiamo visto come funziona il calcolo delle derivate nei software di deep learning, e le differenze tra differenziazione simbolica, numerica, ed automatica. In questa seconda parte, passiamo ad una implementazione didattica in puro Python di un meccanismo di reverse-mode autodiff simile nell'interfaccia a quello reso celebre da PyTorch.

Si è conclusa da poco la terza edizione del TensorFlow Dev Summit, l'evento annuale dedicato al framework di machine learning targato Google. Tra le novità principali sicuramente il rilascio di TensorFlow 2.0 versione alpha, tool per l'aggiornamento automatico da TF 1.x a TF 2.0, oltre a tantissimi rilasci aggiuntivi nell'ecosistema. In questo articolo facciamo il punto sulle news principali e diamo un'…